Orca-Math: Mô hình AI nhỏ của Microsoft Đó là một gã khổng lồ về lượng

Orca-Math sử dụng một kỹ thuật đặc biệt để làm cho nó vượt trội về khả năng suy luận toán học, vượt trội so với các mô hình có kích thước gấp 10 lần

Nhìn thoáng qua

- Nghiên cứu của Microsoft cho thấy ít hơn có thể hiệu quả hơn bằng cách huấn luyện một mô hình AI mini để thực hiện các nhiệm vụ suy luận định lượng một cách xuất sắc.

Microsoft vừa tiết lộ một mô hình ngôn ngữ nhỏ có thể giải các bài toán tốt hơn các mô hình có kích thước gấp 10 lần.

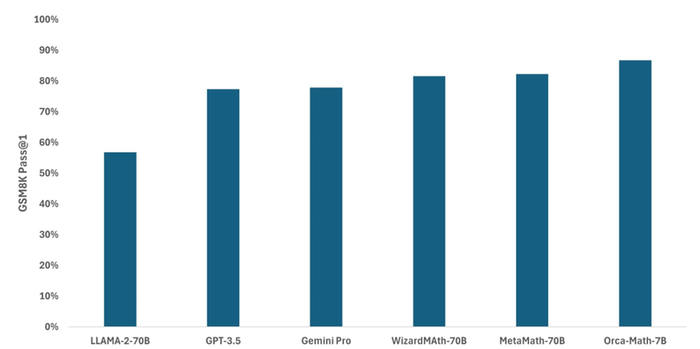

Orca-Math chỉ có bảy tỷ tham số nhưng giải được các bài toán cấp lớp tốt hơn GPT 3.5, Gemini Pro và Llama 2 70B.

Mô hình này là phiên bản tinh chỉnh của Mistral 7B, được huấn luyện trên 200.000 bài toán tổng hợp được tạo ra. Mặc dù tập dữ liệu này nhỏ hơn các tập dữ liệu khác nhưng nhóm nghiên cứu của Microsoft lập luận rằng các mô hình và tập dữ liệu nhỏ hơn cho phép đào tạo nhanh hơn và rẻ hơn.

Trường hợp sử dụng kinh doanh

Các công ty tài chính có thể áp dụng các mô hình AI với khả năng suy luận toán học để tối ưu hóa danh mục đầu tư và lập mô hình rủi ro. Các công ty sản xuất cũng có thể sử dụng nó để tối ưu hóa chuỗi cung ứng và lập mô hình rủi ro – về cơ bản nó có thể được sử dụng ở bất cứ nơi nào doanh nghiệp yêu cầu kỹ năng giải quyết vấn đề định lượng.

Hiện có các mô hình toán học cụ thể có thể hỗ trợ các trường hợp sử dụng này, như WizardMath-70B và MetaMath-70B. Nhưng Orca-Math mới của Microsoft lại vượt trội hơn những cái đó mặc dù nhỏ hơn 10 lần.

Được thử nghiệm trên điểm chuẩn GSM8K, Orca-Math đạt 86,81% trên chỉ số pass@1. Mô hình này hoạt động tốt hơn các hệ thống lớn hơn như Llama 2 (56,8%), WizardMath-70B (81,6%) và thậm chí cả GPT-3.5 (77,4%).

Tín dụng: Microsoft

Orca-Math cũng thể hiện hiệu suất mạnh mẽ trên các bộ dữ liệu toán học khác như AddSub, MultiArith và SinglEq.

Liên quan: 3 vấn đề thường gặp nhất với các mô hình ngôn ngữ nhỏ

Một phần thành công của Orca-Math là việc các nhà nghiên cứu sử dụng quy trình học tập lặp đi lặp lại bên cạnh việc tinh chỉnh. Đây là nơi mô hình được phép thực hành giải quyết vấn đề và liên tục cải tiến dựa trên phản hồi.

“Đối với mọi vấn đề, chúng tôi cho phép SLM tạo ra nhiều giải pháp. Sau đó, chúng tôi sử dụng mô hình giáo viên để cung cấp phản hồi về các giải pháp SLM. Nếu SLM không thể giải quyết vấn đề một cách chính xác, ngay cả sau nhiều lần thử, chúng tôi sẽ sử dụng giải pháp do giáo viên cung cấp,” một bài nghiên cứu cho biết.

“Chúng tôi sử dụng phản hồi của giáo viên để tạo dữ liệu ưu tiên hiển thị cả giải pháp tốt và giải pháp xấu của SLM cho cùng một vấn đề, sau đó đào tạo lại SLM.”

Truy cập mô hình

Các nhà nghiên cứu của Microsoft đã và đang có những bước tiến trong không gian mô hình ngôn ngữ nhỏ đang phát triển. Trước Orca-Math, họ đã xuất bản dòng mô hình Phi, gần đây nhất là Phi-2 , cũng như dòng Orca , tự hào có khả năng suy luận nâng cao.

Để phát triển tập dữ liệu cho Orca-Math, các nhà nghiên cứu của Microsoft đã tạo ra một loạt hệ thống dựa trên tác nhân đề xuất các phương pháp hợp tác để làm cho các bài toán trở nên khó hơn.

Việc lặp lại quy trình qua nhiều vòng dẫn đến các bài toán ngày càng phức tạp, trong đó một tác nhân khác sau đó được sử dụng để xác định xem chúng có thể giải được và tạo ra lời giải hay không.

Liên quan: Microsoft ra mắt Phi-2: Mô hình AI nhỏ nhưng mạnh mẽ

Bạn có thể truy cập tập dữ liệu được sử dụng để xây dựng Orca-Math – tập dữ liệu này có sẵn thông qua Hugging Face và bạn có thể sử dụng tập dữ liệu đó để tinh chỉnh các ứng dụng thương mại của mình.

Không rõ liệu Orca-Math có được cung cấp cho công chúng hay không. AI Business đã liên hệ với Microsoft để làm rõ. Trong thời gian chờ đợi, bạn có thể sử dụng tập dữ liệu để tinh chỉnh mô hình nguồn mở hiện có, như Llama 2 hoặc Bloomz, nhằm cải thiện kỹ năng suy luận toán học của họ.